捐赠管理系统

react.js

位置编码

easyui

android-studio

javafx

hub

算法的时间复杂度和空间复杂度

IT难

浏览器选择建议

网络管理

sass

AI大模型

html网页期末作业

CSDN 橡皮擦

Swagger ui漏洞测试

前后端路腿项目

石油化工

jar

EventBridge

onnx

2024/4/11 18:32:10将yolov8权重文件转为onnx格式并在c#中使用

yolo模型转ONNX

在yolov8中,我们将训练结果的.pt权重文件转换为onnx格式只需要使用ultralytics库中的YOLO类,使用pip安装ultralytics库,然后执行下面python代码

from ultralytics import YOLO# 加载YOLOv8模型

model YOLO("best.pt&q…

Pytorch模型转ONNX部署

开始以为会很困难,但是其实非常方便,下边分两步走:1. pytorch模型转onnx;2. 使用onnx进行inference

0. 准备工作

0.1 安装onnx

安装onnx和onnxruntime,onnx貌似是个环境。。倒是没有直接使用,onnxruntim…

onnx参数出现unk_代表什么

在ONNX模型中,"UNK"代表未知的参数。这通常是由于模型中的某些参数类型不支持或未定义而导致的。 要解决这个问题,您需要检查模型并确保所有参数都已定义并具有正确的类型。如果无法找到问题所在,可以尝试使用ONNX Runtime API来加…

极智AI | 昇腾 CANN ATC 模型转换

欢迎关注我的公众号 [极智视界],获取我的更多笔记分享 大家好,我是极智视界,本文介绍一下 昇腾 CANN ATC 模型转换。 昇腾 CANN 的全称是 Compute Architecture for Neural Networks,是昇腾针对 AI 场景推出的异构计算架构&#x…

onnx 模型切割掉conv后面的节点,设置输出层名称和最后节点名称一致,设置输出层shape和输出节点一致.

某些模型最后卷积层之后的算子不适合在推理引擎里面跑,切割掉conv后面的算子,在cpu上实现有比较好的性能.

包含:

1.获取onnx中间节点的shape的示例

2.增加onnx模型输出,设…

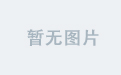

4.36 构建onnx结构模型-Where

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 Where 结点进行分析

方式

方法一…

PyTorch训练,TensorRT部署的简要步骤(采用ONNX中转的方式)

1. 简述

使用PyTorch执行训练,使用TensorRT进行部署有很多种方法,比较常用的是基于INetworkDefinition进行每一层的自定义,这样一来,会反向促使研究者能够对真个网络的细节有更深的理解。

另一种相对简便的方式就是通过ONNX中间…

八. 实战:CUDA-BEVFusion部署分析-分析BEVFusion中各个ONNX

目录 前言0. 简述1. camera.backbone.onnx(fp16)2. camera.backbone.onnx(int8)3. camera.vtransform.onnx(fp16)4. fuser.onnx(fp16)5. fuser.onnx(int8)6. lidar.backbone.xyz.onnx7. head.bbox.onnx(fp16)总结下载链接参考 前言 自动驾驶之心推出的《CUDA与TensorRT部署实战…

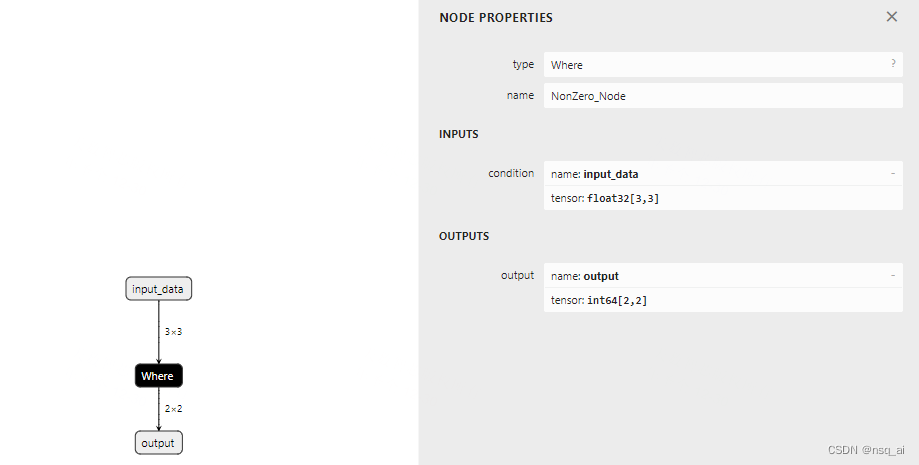

pytorch导出rot90算子至onnx

如何导出rot90算子至onnx 1 背景描述2 等价替换2.1 rot90替换(NCHW)2.2 rot180替换(NCHW)2.3 rot270替换(NCHW) 3 rot导出ONNX 1 背景描述

在部署模型时,如果某些模型中或者前后处理中含有rot90算子,但又希望一起和模型导出onnx时,可能会遇到…

验证onnx格式的yolox

转onnx时decode_in_inference是False,所以需要decode_outputs函数需要注意的是,yolox的Exp中input_size和test_size是先高后宽,即(h,w)

import onnxruntime

import cv2, sys, torch, torchvision

import numpy as npcls_num3

conf_th0.35…

onnx runtime文档学习1-介绍与架构

网上充斥着ONNX runtime的简单科普,却没有一个系统介绍ONNX runtime的博客,因此本博客旨在基于官方文档进行翻译与进一步的解释。ONNX runtime的官方文档:https://onnxruntime.ai/docs/

如果尚不熟悉ONNX格式,可以参照该博客专栏…

TensorRT trtexec 学习笔记

trtexec 实现onnx转tensorrt

./trtexec --onnxtest.onnx --saveEnginetest.gie --verbose --dumpLayerInfo --dumpOutput --dumpProfile其中--verbose 打印log--dumpLayerInfo将每个layer的信息都打印出来--dumpOutput将每个输出都打印到终端上来--dumpProfile打印一些中间分析…

Pytorch实现RNN预测模型并使用C++相应的ONNX模型推理

Pytorch实现RNN模型

代码

import torch

import torch.nn as nnclass RNN(nn.Module):def __init__(self, seq_len, input_size, hidden_size, output_size, num_layers, device):super(RNN, self).__init__()self._seq_len seq_lenself._input_size input_sizeself._output…

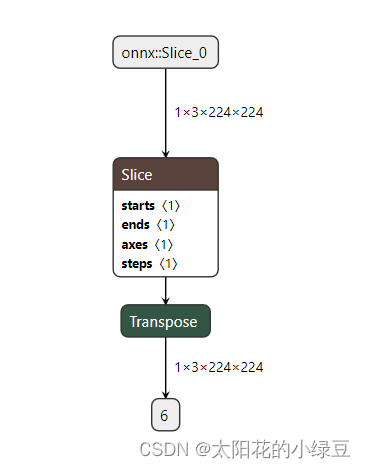

ONNX实践系列-修改yolov5-seg的proto分支输出shape

一、目标

本文主要介绍要将原始yolov5分割的输出掩膜从[b,c,h,.w]修改为[b, h, w, c] 原来的: 目标的: 代码如下:

Descripttion:

version:

@Company: WT-XM

Author: yang jinyi

Date: 2023-09-08 11:26:28

LastEditors: yang jinyi

LastEditTime: 2023-09-08 11:48:01

…

Yolov5 (v6.2) 使用自己的数据训练分类模型 基于ONNX TensorRT转换

前言

之前文章已经讲过yolov5模型的训练,这一篇将说一下分类模型训练流程。 https://blog.csdn.net/qq_45066628/article/details/129470290

新版本简介

YOLOv5官方发布了v6.2版本,v6.2版本支持分类模型训练、验证、预测和导出;v6.2版本的…

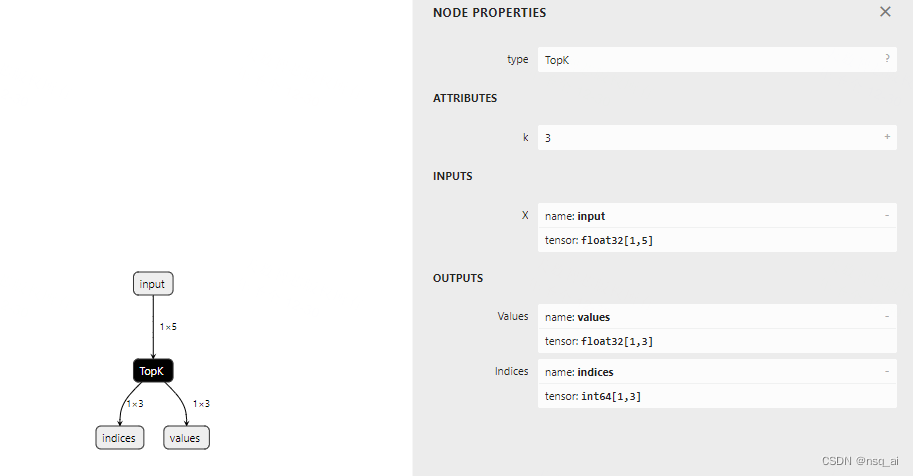

4.30 构建onnx结构模型-TopK

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 TopK 结点进行分析 方式

方法一&a…

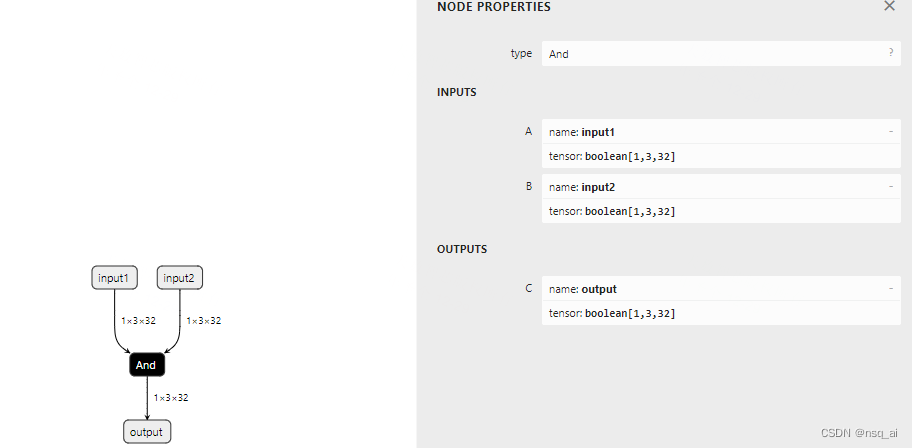

4.16 构建onnx结构模型-And

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 And 结点进行分析

方式

方法一&…

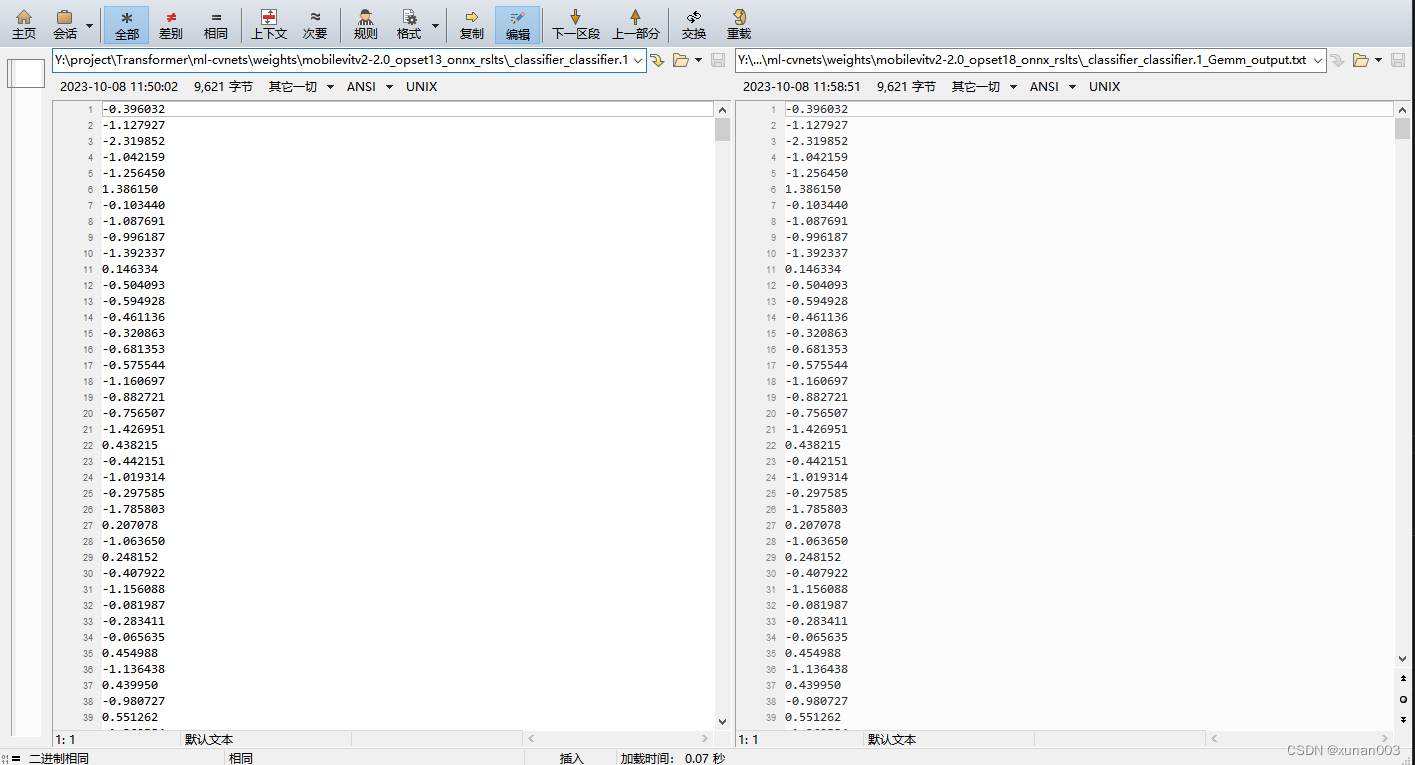

MobileViT v2导出onnx模型时遇Col2Im算子无法导出问题

相关error log索引

onnxruntime.capi.onnxruntime_pybind11_state.InvalidGraph: [ONNXRuntimeError] : 10 : INVALID_GRAPH : This is an invalid model. In Node, ("/classifier/classifier.0/ReduceMean", ReduceMean, "", -1) : ("/layer_5/laye…

4.4 获取onnx每个节点的输出结果

前言

获取onnx每个节点的结果,进行输出显示、保存

Code

import os

import onnx

import onnx.helper as helper

import onnxruntime

from collections import OrderedDict

import numpy as npdef get_onnx_node_out(onnx_file, save_onnx):model onnx.load(onnx…

4.35 构建onnx结构模型-Layernorm

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 Layernorm 结点进行分析 方式

方法…

pytorch训练图像分类模型,并部署到MNN

1. Pytorch分类器网络

# 定义一个简单的分类网络

class SimpleNet(nn.Module):def __init__(self):super(SimpleNet, self).__init__()# 三个卷积层用于提取特征# 1 input channel image 90x90, 8 output channel image 44x44self.conv1 nn.Sequential(nn.Conv2d(in_channels…

ONNXRuntime模型推理

直接贴code

加载,推理

import onnxruntime as ort

import torch

import timeimport cv2

import numpy as npdef time_sync():if torch.cuda.is_available():torch.cuda.synchronize()return time.time()ort_session ort.InferenceSession(./semseg.onnx)

onnx_inp…

修改和调试 onnx 模型

1. onnx 底层实现原理

1.1 onnx 的存储格式

ONNX 在底层是用 Protobuf 定义的。Protobuf,全称 Protocol Buffer,是 Google 提出的一套表示和序列化数据的机制。使用 Protobuf 时,用户需要先写一份数据定义文件,再根据这份定义文…

TensorRT加速推理入门-1:Pytorch转ONNX

这篇文章,用于记录将TransReID的pytorch模型转换为onnx的学习过程,期间参考和学习了许多大佬编写的博客,在参考文章这一章节中都已列出,非常感谢。 1. 在pytorch下使用ONNX主要步骤

1.1. 环境准备

安装onnxruntime包 安装教程可…

HuggingFace Transformers 模型导出到 ONNX 格式

HuggingFace Transformers 模型导出到 ONNX 格式 0. 引言1. 使用 Optimum2. 使用 transformers.onnx 导出模型 0. 引言

ONNX 是一种开放格式,用于表示机器学习模型。ONNX 定义了一组通用运算符(机器学习和深度学习模型的构建基块)和通用文件…

模型推理加速系列|如何用ONNX加速BERT特征抽取-part2(附代码)

背景

本文紧接之前的一篇文章如何用ONNX加速BERT特征抽取,继续介绍如何用ONNXONNXRuntime来加速BERT模型推理。如果看过之前的那篇文章如何用ONNX加速BERT特征抽取的童鞋估计还记得文中留了一个疑问:为何优化过的ONNX模型与未优化的ONNX性能相近&#x…

复杂onnx解决方案(以sparseconv为例)

目录 前言1. 稀疏卷积2. Sparse Convolution Model2.1 输入数据模型2.2 卷积核2.3 输出的定义2.4 计算流程2.4.1 构建 hash table2.4.2 构建 Rulebook2.4.3 在GPU上计算Pipeline 2.5 Summary 3. SCN导出3.1 实现trace3.2 导出onnx3.3 CenterPoint SCN导出3.4 执行图的构建3.5 o…

解决:抠图时onnxruntime错误-无法加载“onnxruntime_providers_tensorrt.dll“-错误代码“126”

文章目录 (一)问题(二)假装分析(三)解决 (一)问题

在这篇:🔗《探索【Stable-Diffusion WEBUI】的附加功能:图片缩放&抠图》里面,…

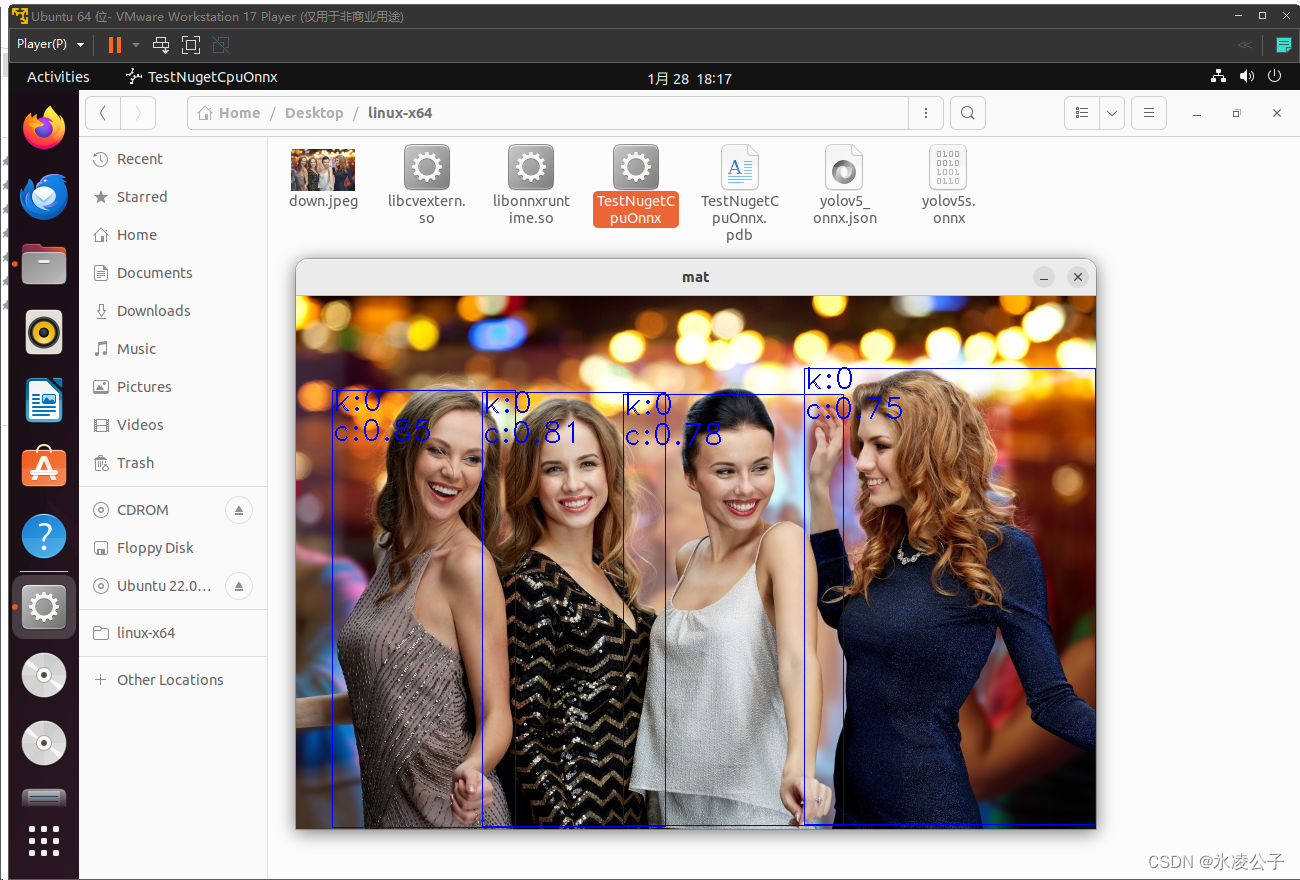

C#简单使用Yolov5的Onnx格式模型进行目标检测

背景

最近要离职了,同事需要了解一下C#如何使用yolov5系列onnx格式模型进行目标检测,由于其对C#不熟练,可能会影响公司后续的开发进度,所以趁着还在,赶紧把手尾搞好。

方案

1、创建一个C# DotNet 8 控制台项目[可千…

【YOLO】目标识别模型的导出和opencv部署

文章目录 0 前期教程1 什么是模型部署2 怎么部署 0 前期教程 【YOLO】朴实无华的yolov5环境配置 【YOLO】yolov5训练自己的数据集

1 什么是模型部署 前期教程当中,介绍了yolov5环境的搭建以及如何利用yolov5进行模型训练和测试,虽然能够实现图片或视频…

记录pytorch实现自定义算子并转onnx文件输出

概览:记录了如何自定义一个算子,实现pytorch注册,通过C编译为库文件供python端调用,并转为onnx文件输出

整体大概流程:

定义算子实现为torch的C版本文件注册算子编译算子生成库文件调用自定义算子

一、编译环境准备…

ONNX: export failure ❌ 0.0s: Unsupported ONNX opset version: 17

yolov5s.pt转onnx报错:ONNX: export failure ❌ 0.0s: Unsupported ONNX opset version: 17

参考

https://github.com/Hexmagic/ONNX-yolov5/issues/13https://github.com/ultralytics/yolov5/blob/ac6c4383bc0c7a2a4f7ca18f8733821b49e916bd/export.py#L908

描述…

学习笔记:在华为昇腾NPU上进行深度学习项目【未完待续】

在NPU上做深度学习算法 场景和功能说明系统信息查询1、场景一:非NPU上训练的模型推理1.1 执行方案1.2 学习案例1.3 onnx转om1.4 om推理 昇腾社区链接:

昇腾社区-官网丨昇腾万里 让智能无所不及 场景和功能说明

第一种:在cpu或gpu上训练的模…

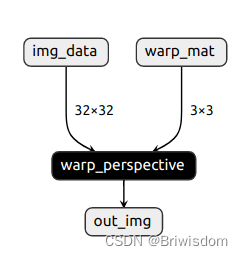

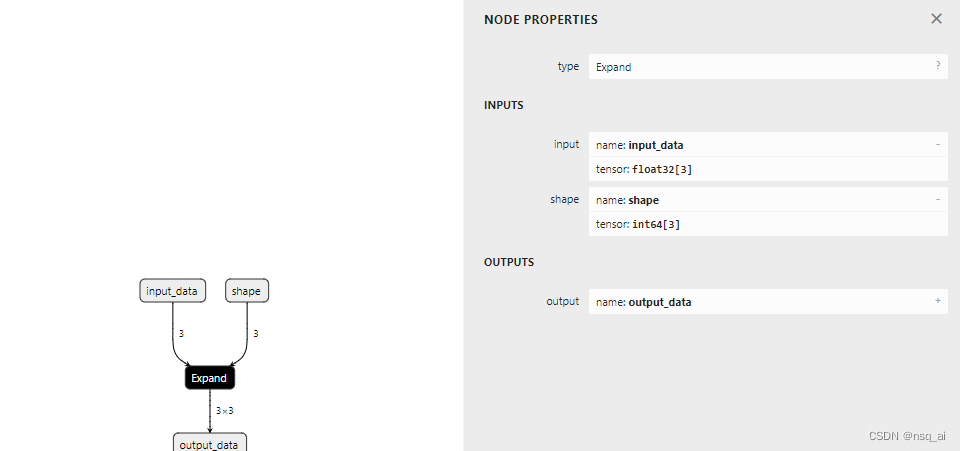

4.33 构建onnx结构模型-Expand

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 Expand 结点进行分析 方式

方法一…

【已解决】pt文件转onnx后再转rknn时得到推理图片出现大量锚框变花屏

前言

环境介绍:

1.编译环境

Ubuntu 18.04.5 LTS

2.RKNN版本

py3.8-rknn2-1.4.0

3.单板

迅为itop-3568开发板 一、现象

采用yolov5训练并将pt转换为onnx,再将onnx采用py3.8-rknn2-1.4.0推理转换为rknn,rknn模型能正常转换,…

TensorRT转换onnx的Transpose算子遇到的奇怪问题

近来把一个模型导出为onnx并用onnx simplifier化简后转换为TensorRT engine遇到非常奇怪的问题,在我们的网络中有多个检测头时,转换出来的engine的推理效果是正常的,当网络中只有一个检测头时,转换出来的engine的推理效果奇差&…

onnx模型转换opset版本和固定动态输入尺寸

背景:之前我想把onnx模型从opset12变成opset12,太慌乱就没找着,最近找到了官网上有示例的,大爱onnx官网,分享给有需求没找着的小伙伴们。

1. onnx模型转换opset版本

官网示例:

import onnx

from onnx im…

pytorch实现DCP暗通道先验去雾算法及其onnx导出

pytorch实现DCP暗通道先验去雾算法及其onnx导出 简介实现ONNX导出导出测试 简介

最近在做图像去雾,于是在Pytorch上复现了一下dcp算法。暗通道先验去雾算法是大神何恺明2009年发表在CVPR上的一篇论文,还获得了当年的CVPR最佳论文。

实现

具体原理就不…

deepsort使用ONNX模型进行加速

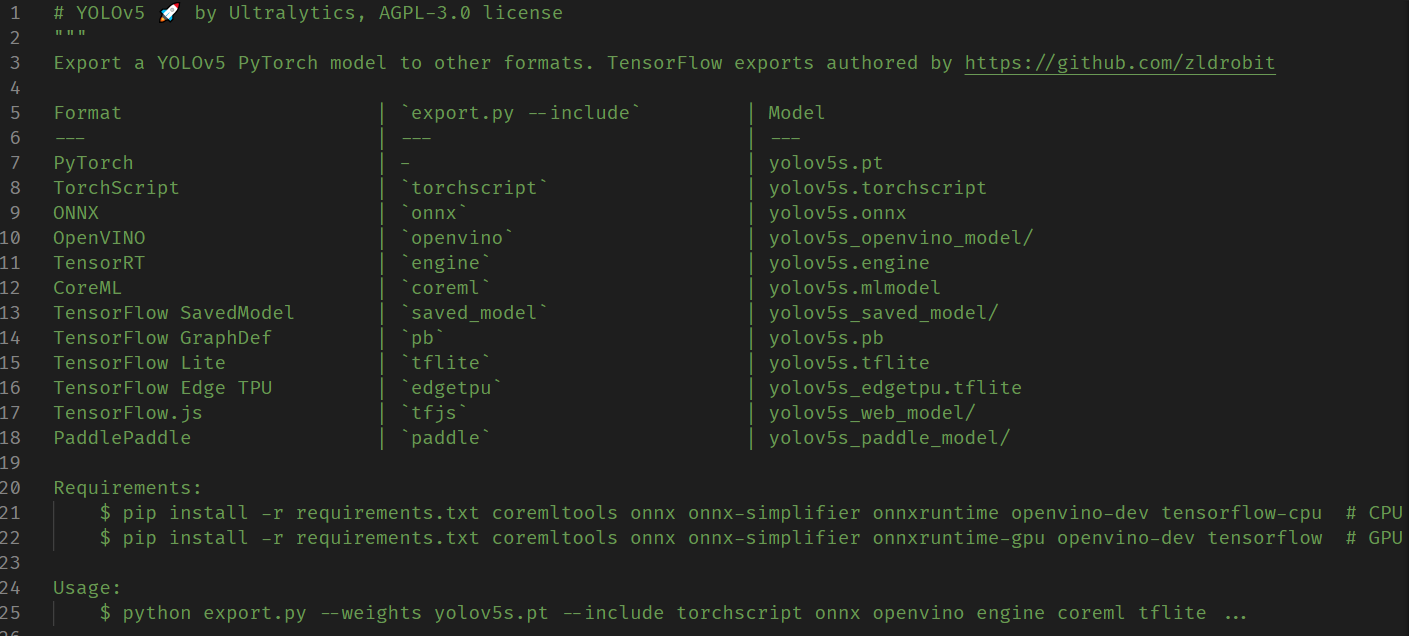

导出Onnx模型

我们主要是对yolov5的推理进行改进,我们使用yolov5自带的export.py文件对模型进行导出 参见yolov5官网(6.0版本之后才有) python export.py --weights yolov5s.pt --include torchscript onnx 备注:在导出前需要先安装onnx库

输出如下: export: data=data/…

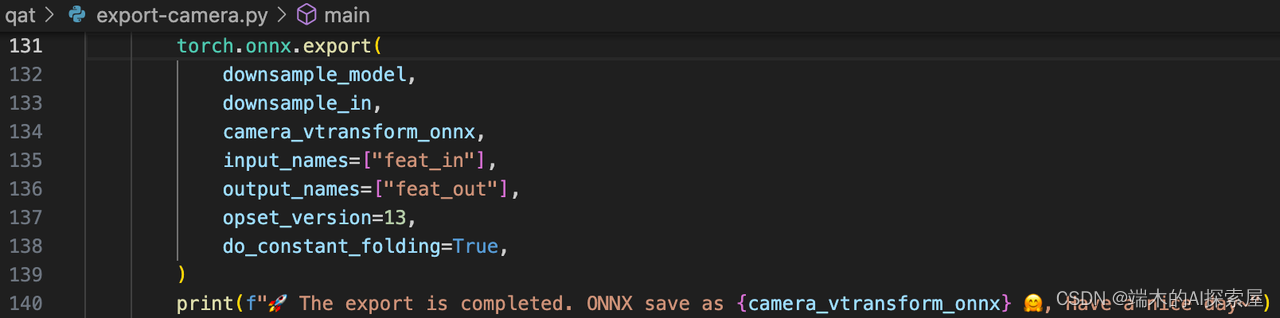

MIT-BEVFusion系列八--onnx导出1 综述及相机网络导出

目录 综述export-camera.py加载模型加载数据生成需要导出成 onnx 的模块Backbone 模块VTransform 模块 生成 onnx使用 pytorch 原生的伪量化计算方法导出 camera.backbone.onnx导出 camera.vtransform.onnx 综述

bevfusion的各个部分的实现有着鲜明的特点,并且相互…

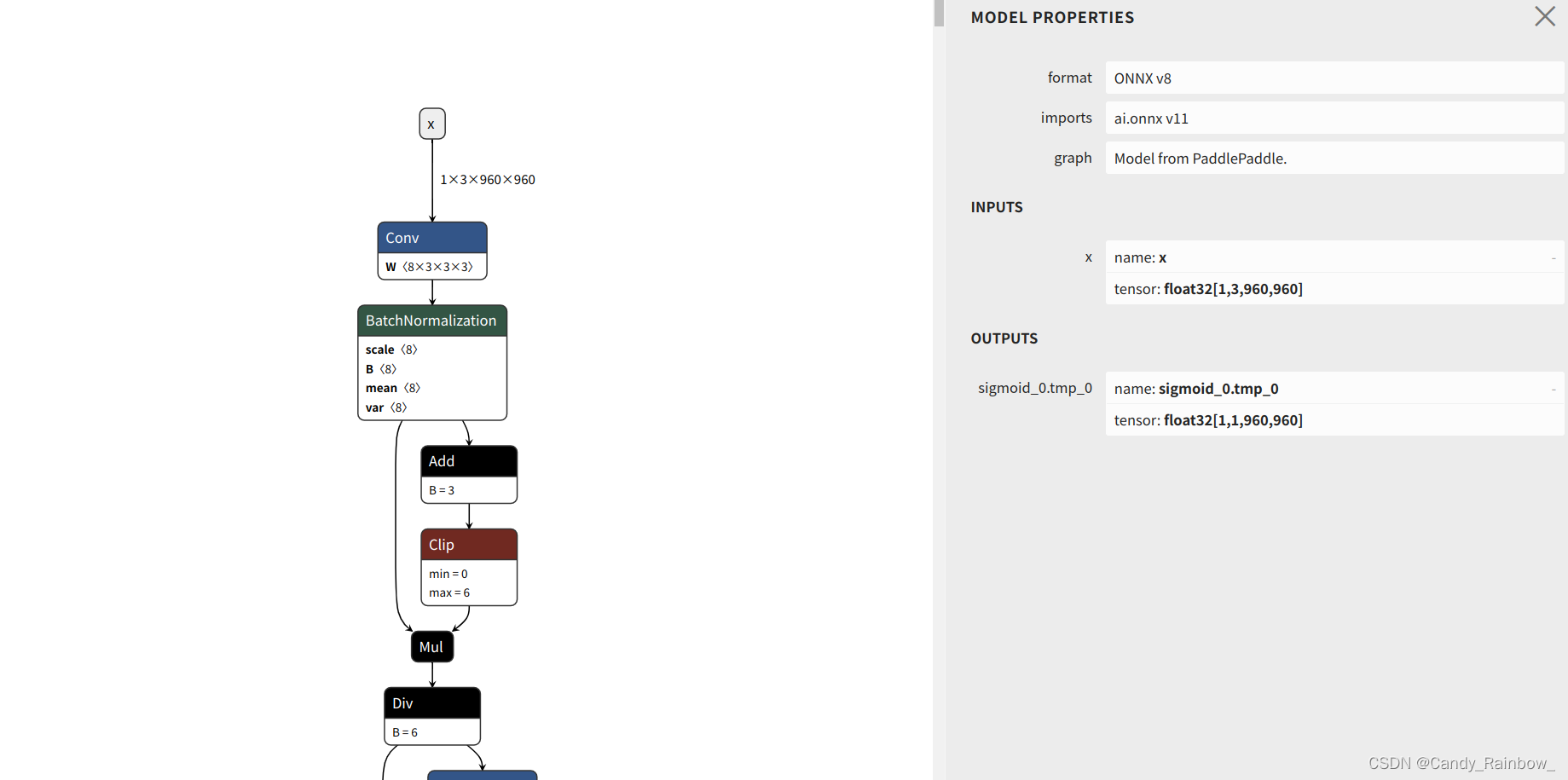

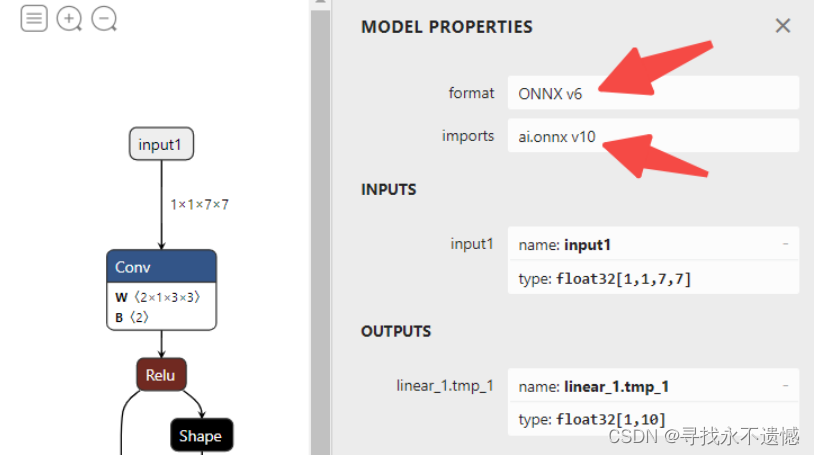

ONNX的结构与转换

ONNX的结构与转换 1. 背景2. ONNX结构分析与修改工具2.1. ONNX结构分析2.2. ONNX的兼容性问题2.3. 修改ONNX模型 3. 各大深度学习框架如何转换到ONNX?3.1. MXNet转换ONNX3.2. TensorFlow模型转ONNX3.3. PyTorch模型转ONNX3.4. PaddlePaddle模型转ONNX3.4.1. 简介3.4…

tensorflow转onnx记录

安装tf2onnx以及onnxruntime

pip install onnxruntime

pip install tf2onnxtf 转为onnx步骤为如下:

将tf动态图冻结,生成冻结后的pb文件使用tf2onnx 将pb文件转为onnx文件

将tf动态图冻结使用如下代码:

def export_frozen_graph(model, m…

使用rknn-toolkit2将paddleseg模型导出rknn模型

目录 安装paddle2onnx环境

将paddle模型导出onnx模型

安装rknn-toolkits

转化rknn模型 安装paddle2onnx环境

首先创建一个python虚拟环境

conda create -n paddle2onnx python3.10

source activate paddle2onnx

下载并安装 https://github.com/PaddlePaddle/Paddle2ONNX …

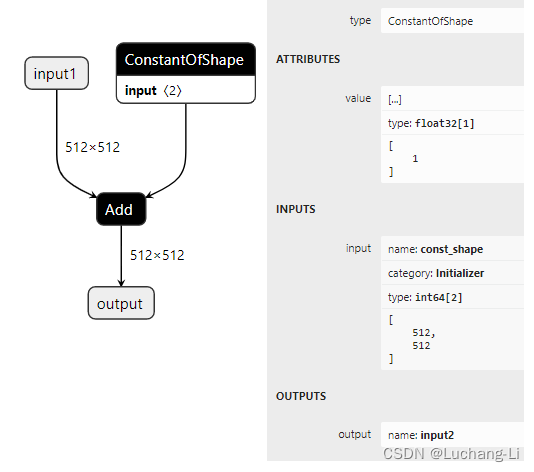

一种大于2GB ONNX模型onnxsim优化方法

大于2GB模型onnxsim优化很耗时,容易挂掉,而且需要特别大的系统内存。

这里提出一种比较简单的优化大于2GB ONNX模型的方法:

基本思路是

把卷积和矩阵乘的权重(参数量大于某个阈值)替换为ConstantOfShape,…

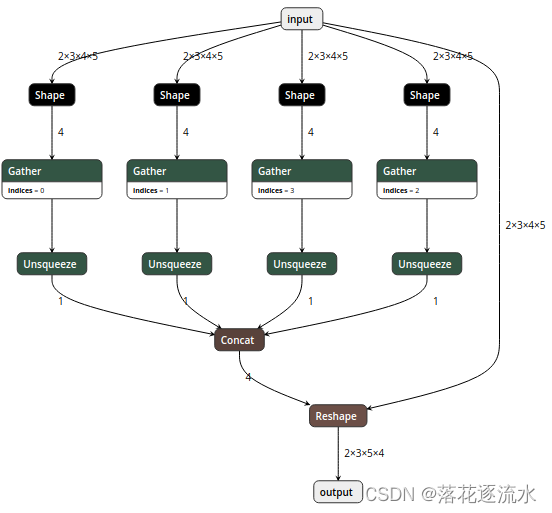

4.1 构建onnx结构模型-Reshape

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以reshape 结点进行分析

方式

方法一:pytorch --> onnx

固定shape

import torchcla…

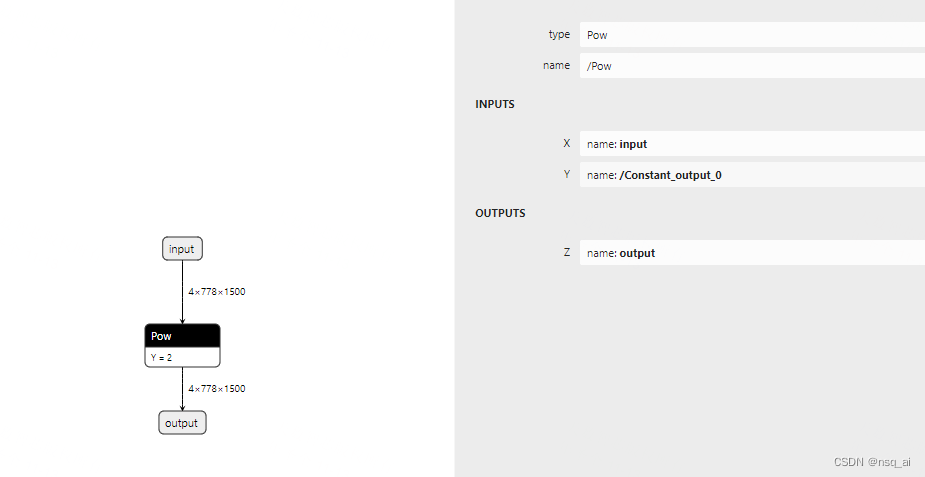

4.5 构建onnx结构模型-Reshape

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以pow 结点进行分析

方式

方法一&am…

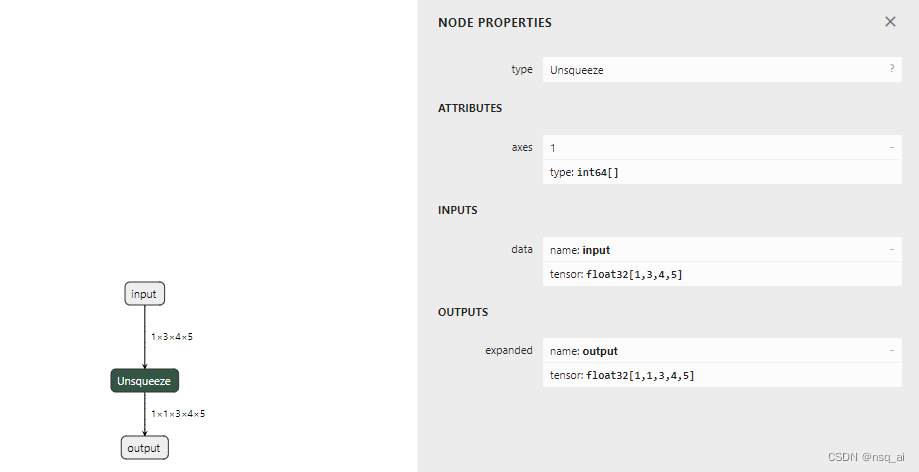

4.27 构建onnx结构模型-Unsuqeeze

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 Unsuqeeze 结点进行分析 方式

方法…

pdmodel从动态模型转成静态onnx

1.下载项目

git clone https://github.com/jiangjiajun/PaddleUtils.git

2.新建两个新的文件夹

第一个文件夹放两个必要文件

第二个文件夹可以设置为空,用来存放转换后的模型

如图: 3.在终端运行 python paddle/paddle_infer_shape.py --model_dir …

ONNXRuntimer Server

OnnxRuxtime 是开放神经网络交换格式的运行库。 ONNX是一种通用的神经网络描述格式,可以从其它神经网络框架格式,如pytorch, tensorflow, caffe等转换到onnx格式进行统一表示。

OnnxRuntime, 顾名思义,就是用来运行onnx格式神经网络模型的一…

onnx和mnn调用pytorch模型

1. 训练代码

pytorch自身部署较麻烦,一般使用onnx和mnn较为实用

训练模型的代码:

import torch

import torch.nn as nn

import torchvision

import torchvision.transforms as transforms

import torch.optim as optim

from torch.optim import lr_…

onnx模型可视化方法

onnx(Open Neural Network Exchange,开放神经网络交换)格式,是一个用于表示深度学习模型的标准,可使模型在不同框架之间进行转移,在使用pytorch框架好模型后需要部署到边缘端,.pth不大适合部署边缘端环境,最…

2023-简单点-什么是onnx?

onnx

open neural network exchange 开放神经网络交换

mother: 微软和fb

是一种模型的开放格式,跨平台兼容格式

优势在?

跨平台呀 不要再考虑 x86啊,arch64 等不同cpu架构

劣势?

听说老改动; 资料比较乱&#x…

【PaddlePaddle onnx】PaddlePaddle导出ONNX及模型可视化教程

文章目录1 背景介绍2 实验环境3 paddle.onnx.export函数简介4 代码实操4.1 PaddlePaddle与ONNX模型导出4.2 ONNX正确性验证4.3 PaddlePaddle与ONNX的一致性检查4.4 多输入的情况5 ONNX模型可视化6 ir_version和opset_version修改7 致谢原文来自于地平线开发者社区,未…

人工智能模型转ONNX 连接摄像头使用ONNX格式的模型进行推理

部署之后模型的运算基本上能快5倍。本地部署之后,联网都不需要,数据和隐私不像在网上那样容易泄露了。

模型部署的通用流程 各大厂商都有自己的推理工具。 训练的归训练,部署的归部署,人工智能也分训练端和部署端,每一…

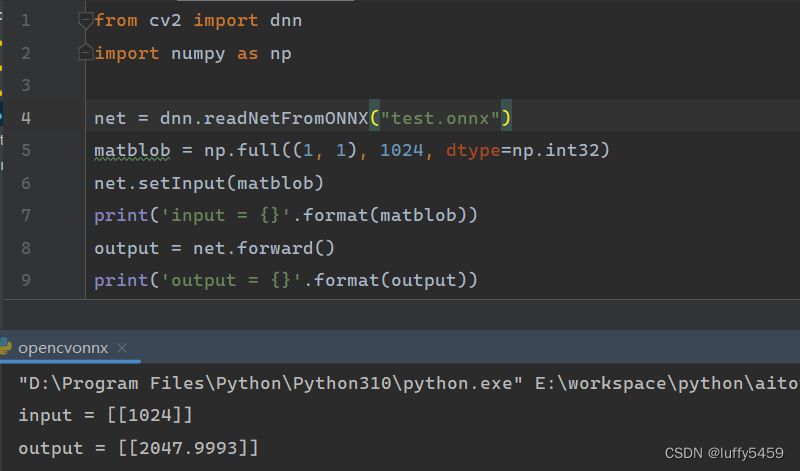

opencv-python加载pytorch训练好的onnx格式线性回归模型

opencv是一个开源的图形库,有针对java,c,python的库依赖,它本身对模型训练支持的不好,但是可以加载其他框架训练的模型来进行预测。 这里举一个最简单的线性回归的例子,使用深度学习框架pytorch训练模型,最后保存模型为…

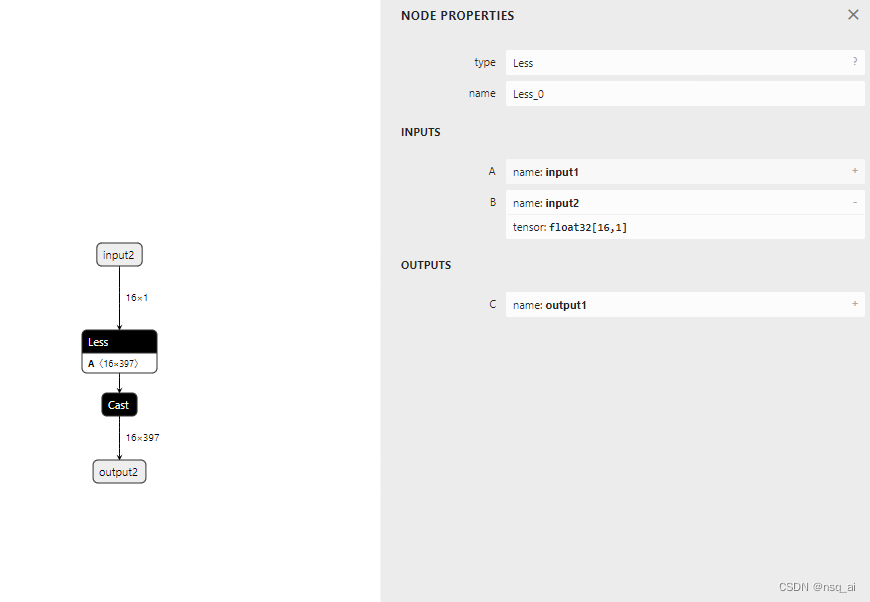

4.8 构建onnx结构模型-Less

前言

构建onnx方式通常有两种: 1、通过代码转换成onnx结构,比如pytorch —> onnx 2、通过onnx 自定义结点,图,生成onnx结构

本文主要是简单学习和使用两种不同onnx结构, 下面以 Less 结点进行分析 方式

方法一&a…

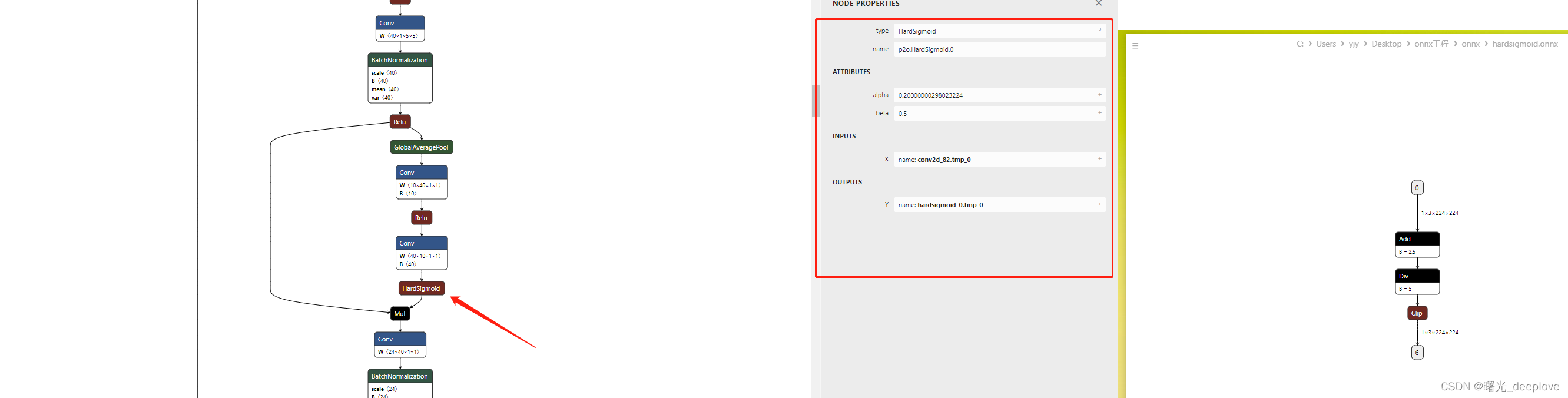

ONNX实践系列-将dbnet.onnx的hardsigmoid op用hardsigmoid.onnx整个去替换掉

一、目标

这个dbnet.onnx是paddleocr转出来的,自带的有paddle的那个hardsigmoid算子 ,这个不好转到trt等框架,因此我们想把这个hardsigmoid 算子op替换成我们常规的pytorch框架转出来的hardsigmoid onnx那种。 二、做法 给出代码如下:

import onnx

from onnx import help…

验证onnx格式的YOLO

相关参数改成自己的注意输出的shape,onnx有时候会合并输出,目前不知道什么原因

import onnxruntime

import cv2, torch

import numpy as npanchors[[22, 55, 38, 44, 32, 88, 70, 56], [22, 22, 17, 35, 37, 24, 27, 34]]

anslen(anchors[0])/…

TensorRT解析onnx模型

目录 TensorRT简介

ONNX模型部署详细步骤

1.解析onnx模型,并保存序列化推理引擎文件 TensorRT简介

TensorRT是nvidia公司针对nvidia显卡训练的模型在特定平台进行加速的推理优化库,是一个c库,仅支持推理,不支持训练;…

Pytorch模型转成ONNX和MNN

简介

本文介绍Pytorch模型转成ONNX和MNN模型,ONNX和MNN框架不做详细介绍。

PyTorch转ONNX

需要安装好pytorch环境和onnx包

pip install torch

pip install onnx以mobilenet为例,下载好mobilenet.py和预训练模型mobilenet_v2-b0353104.pth,…